- GRAVIMÉTRIE

- GRAVIMÉTRIELa gravimétrie a pour objet la mesure de l’intensité de la pesanteur en un point donné, et elle exploite les résultats de cette mesure, effectuée en un grand nombre de stations. L’intensité de la pesanteur étant directement liée à l’attraction subie par l’instrument de la part des différentes parties du globe terrestre, compte tenu de la force centrifuge due à la rotation, la gravimétrie apporte une information sur la répartition des masses internes. Toutefois, elle ne permet pas de la déterminer complètement.L’exploitation des mesures conduit à deux types de résultats: dans le cas d’une région restreinte, la gravimétrie est une méthode de prospection qui peut fournir des informations sur les structures géologiques; elle participe ainsi, indirectement, à la recherche de pétrole et, directement, à la découverte de minerais denses ou, au contraire, de cavités; à l’échelle de la planète, ou de vastes régions, la gravimétrie est une des disciplines de la géodésie, qui se propose de déterminer la forme d’ensemble du globe terrestre.1. DéfinitionsLa pesanteur, force qui s’exerce, suivant la verticale, sur l’unité de masse, est le gradient d’une fonction scalaire F, le potentiel de la pesanteur, qui vérifie – dans le vide – l’équation de Laplace:

en d’autres termes, F est une fonction harmonique.Parmi les surfaces équipotentielles (qui sont horizontales par définition), celle qui coïncide avec le niveau moyen des mers est appelée «géoïde»; c’est la surface de référence à laquelle sont rapportées toutes les mesures topographiques. La détermination de la forme exacte du géoïde est l’objet essentiel de la géodésie, mais l’étude du géoïde ne peut être séparée de celle du champ de pesanteur dans son ensemble.La pesanteur que nous observons est la résultante de la gravité – effet de l’attraction newtonienne exercée par toutes les parties de la Terre – et de la force centrifuge due à la rotation de la planète. L’effet des autres astres (Lune, Soleil), dont l’attraction globale détermine le mouvement du centre de masse de la Terre, se réduit, aux différents points de la surface, à un effet différentiel périodique, la marée (ou plutôt, la force génératrice de la marée). Tant la force centrifuge que cet effet différentiel sont calculables avec précision. Le seul point délicat est que, sous l’action de la force de marée, la Terre se déforme, ce qui modifie son attraction propre, en intensité comme en direction. L’étude de ces variations, appelées «marées gravimétriques», est très délicate, car leur amplitude n’est que de l’ordre du dix millionième de l’intensité de la pesanteur; cette étude apporte une information sur l’élasticité du globe terrestre. Ces marées gravimétriques entraînent une légère incertitude dans le calcul des corrections dites de marée qu’il convient d’apporter aux mesures de la pesanteur (le coefficient multiplicateur, par rapport à l’effet théorique pour un globe rigide, est compris entre 1,1 et 1,2).Le mouvement des satellites artificiels obéit au seul effet de la gravité, et l’observation de leurs trajectoires, aujourd’hui menée avec une très grande précision, apporte sur la forme d’ensemble du champ de gravité des informations essentielles. Les trois voies inséparables pour accéder à une connaissance globale du champ de la pesanteur, dont la forme du géoïde n’est qu’un aspect, sont:– la mesure, par triangulations et trilatérations, des distances entre des stations où les coordonnées astronomiques (latitude, longitude et azimut d’une direction) sont connues, c’est-à-dire la géodésie stricto sensu;– l’étude des trajectoires des satellites;– la gravimétrie.Mesurant une dérivée, la gravimétrie est particulièrement indiquée pour l’étude des structures fines, locales. Mentionnons pour mémoire qu’il est possible de mesurer certaines dérivées secondes du potentiel; les tentatives pour mesurer la dérivée seconde verticale – gradient vertical de la pesanteur – n’ont pratiquement donné aucun résultat utile à terre (la mesure a été envisagée à bord d’un satellite). Les dérivées horizontales de la pesanteur peuvent être mesurées grâce à une balance de torsion, dont le modèle le plus achevé est celui de Roland, baron von Eötvös. Cet instrument a été utilisé pour la prospection entre 1920 et 1940, avant l’apparition des gravimètres. Il est aujourd’hui abandonné, en particulier parce qu’il est par trop sensible à des influences purement locales.2. La mesure de la pesanteurLa théorie newtonienne de la gravitation prévoyant des variations de l’intensité de la pesanteur selon les lieux, l’observation du pendule apparaissait comme la manière la plus simple de les mettre en évidence.L’intensité de la pesanteur figure en effet dans la formule qui donne la période du pendule simple de longueur l :

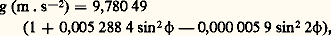

en d’autres termes, F est une fonction harmonique.Parmi les surfaces équipotentielles (qui sont horizontales par définition), celle qui coïncide avec le niveau moyen des mers est appelée «géoïde»; c’est la surface de référence à laquelle sont rapportées toutes les mesures topographiques. La détermination de la forme exacte du géoïde est l’objet essentiel de la géodésie, mais l’étude du géoïde ne peut être séparée de celle du champ de pesanteur dans son ensemble.La pesanteur que nous observons est la résultante de la gravité – effet de l’attraction newtonienne exercée par toutes les parties de la Terre – et de la force centrifuge due à la rotation de la planète. L’effet des autres astres (Lune, Soleil), dont l’attraction globale détermine le mouvement du centre de masse de la Terre, se réduit, aux différents points de la surface, à un effet différentiel périodique, la marée (ou plutôt, la force génératrice de la marée). Tant la force centrifuge que cet effet différentiel sont calculables avec précision. Le seul point délicat est que, sous l’action de la force de marée, la Terre se déforme, ce qui modifie son attraction propre, en intensité comme en direction. L’étude de ces variations, appelées «marées gravimétriques», est très délicate, car leur amplitude n’est que de l’ordre du dix millionième de l’intensité de la pesanteur; cette étude apporte une information sur l’élasticité du globe terrestre. Ces marées gravimétriques entraînent une légère incertitude dans le calcul des corrections dites de marée qu’il convient d’apporter aux mesures de la pesanteur (le coefficient multiplicateur, par rapport à l’effet théorique pour un globe rigide, est compris entre 1,1 et 1,2).Le mouvement des satellites artificiels obéit au seul effet de la gravité, et l’observation de leurs trajectoires, aujourd’hui menée avec une très grande précision, apporte sur la forme d’ensemble du champ de gravité des informations essentielles. Les trois voies inséparables pour accéder à une connaissance globale du champ de la pesanteur, dont la forme du géoïde n’est qu’un aspect, sont:– la mesure, par triangulations et trilatérations, des distances entre des stations où les coordonnées astronomiques (latitude, longitude et azimut d’une direction) sont connues, c’est-à-dire la géodésie stricto sensu;– l’étude des trajectoires des satellites;– la gravimétrie.Mesurant une dérivée, la gravimétrie est particulièrement indiquée pour l’étude des structures fines, locales. Mentionnons pour mémoire qu’il est possible de mesurer certaines dérivées secondes du potentiel; les tentatives pour mesurer la dérivée seconde verticale – gradient vertical de la pesanteur – n’ont pratiquement donné aucun résultat utile à terre (la mesure a été envisagée à bord d’un satellite). Les dérivées horizontales de la pesanteur peuvent être mesurées grâce à une balance de torsion, dont le modèle le plus achevé est celui de Roland, baron von Eötvös. Cet instrument a été utilisé pour la prospection entre 1920 et 1940, avant l’apparition des gravimètres. Il est aujourd’hui abandonné, en particulier parce qu’il est par trop sensible à des influences purement locales.2. La mesure de la pesanteurLa théorie newtonienne de la gravitation prévoyant des variations de l’intensité de la pesanteur selon les lieux, l’observation du pendule apparaissait comme la manière la plus simple de les mettre en évidence.L’intensité de la pesanteur figure en effet dans la formule qui donne la période du pendule simple de longueur l : et dans la formule analogue pour le pendule composé. Au cours de sa célèbre expédition en Équateur, pour la mesure d’un arc de méridien, Pierre Bouguer a fait de nombreuses études sur la variation de g avec l’altitude et la latitude, en utilisant un pendule fait d’un corps suspendu à un fil dont il mesurait la longueur avec une règle. Mais la précision de ces mesures était faible. Elles ont été reprises par Charles de Borda, qui s’est efforcé de réaliser un pendule de forme connue (sphère suspendue à un fil). L’invention du pendule réversible a permis des résultats plus précis: si un pendule composé a la même période lorsqu’il oscille autour de deux axes parallèles convenablement disposés, on démontre que cette période est celle du pendule simple ayant pour longueur la distance des axes. On a pu obtenir ainsi une précision avoisinant le 1/100 000, mais non la dépasser (M. de Kaster, 1818; Friedrich Kühnen et Philipp Furtwängler, Potsdam, 1906).La comparaison de la période d’un pendule invariable avec l’heure transmise par radio a permis d’obtenir, moyennant des précautions sur lesquelles on n’insistera pas, une précision relative de l’ordre du 1/1 000 000. Il était alors possible de mesurer les différences de gravité entre deux points, avec une précision très supérieure à celle des mesures absolues. Pour assurer l’homogénéité du réseau des mesures, il a été décidé d’adopter conventionnellement la valeur mesurée à Potsdam et de mesurer, à partir de là, des différences de gravité.L’apparition des gravimètres, entre 1930 et 1940, a encore accentué les difficultés de cette situation. Un gravimètre est un système de ressorts et de masses mobiles, disposé de manière à se trouver à la limite de la stabilité, ce qui se traduit par une période d’oscillation très longue (par exemple, 6 secondes pour un dispositif de quelques centimètres). Il en résulte qu’une variation de g correspond à une déformation relativement importante, qu’un mode d’observation sensible peut mettre en évidence; le plus souvent, on annule cette déformation par un dispositif de compensation qui permet la mesure. Pour qu’une erreur de nivellement équivalente à l’action de forces horizontales soit sans effet, il faut que le déplacement de la masse se fasse suivant la verticale et que les points de suspension soient dans le plan horizontal du centre de masse de l’équipage mobile. Les effets thermiques sont corrigés par l’emploi de ressorts convenables (en quartz, en invar, ou bimétalliques) et, de plus, la plupart des gravimètres sont maintenus à température constante par un chauffage approprié, avec deux enceintes concentriques à des températures légèrement différentes. L’emploi de plusieurs masses de densités distinctes permet de corriger l’effet des variations de la densité de l’air sur la poussée d’Archimède. De nombreux gravimètres, assez rustiques pour être transportés avec un minimum de précautions, ont été réalisés suivant ces principes. Ils peuvent être mis en station et fournir une mesure en un temps de l’ordre de la minute. Cependant, ils ne donnent pas de mesures absolues, et les différences de gravité que décèlent leurs lectures doivent faire l’objet d’un étalonnage, entre des stations où la gravité est connue. Il faut aussi tenir compte d’une dérive, en gros proportionnelle au temps, en réoccupant périodiquement les mêmes stations. La sensibilité atteint 10-9, c’est-à-dire le microgal (g est de l’ordre de 981 Gal), la fidélité 0,1 mGal (1 Gal = 0,01 m . s-2).La facilité d’emploi des gravimètres a conduit à l’occupation de millions de stations qui constituent des réseaux localement très cohérents (à une fraction de mGal près), mais dont les calages relatifs paraissaient beaucoup moins assurés. On a repris, parallèlement, les liaisons à grande distance soit à l’aide de pendules invariables, soit par transport de gravimètres (entre stations où les valeurs de g sont très proches). On peut ainsi constituer un réseau mondial de bases, dont la cohérence est de l’ordre du mGal, et auquel tous les réseaux locaux devraient (théoriquement) être reliés. Ce travail de contrôle, exécuté en fait après coup, n’a pas mis en évidence de divergences trop graves entre les valeurs provisoirement admises.Les techniques de la physique ont accompli, entre-temps, des progrès considérables dans la mesure précise d’intervalles de temps très courts. Vers 1960, il est devenu possible d’envisager une mesure de g directe par l’étude de la chute libre d’un corps, au lieu d’employer la voie indirecte de son intégration dans le mouvement du pendule, voie qui s’était imposée depuis Galilée. Différents laboratoires ont entrepris des mesures «absolues» de g selon ce principe. Deux méthodes peuvent être envisagées. Ou bien on laisse tomber une règle divisée, et on la photographie à intervalles de temps connus en un point fixe. Ou bien on jette vers le haut un corps, et on chronomètre ses quatre passages en deux points dont la distance verticale est connue, en s’arrangeant pour mesurer directement cette distance, par un procédé interférentiel; bien entendu, l’expérience se fait dans le vide. La principale cause d’erreur est finalement constituée par les vibrations microsismiques des supports, mais rien n’empêche de répéter un grand nombre de fois l’expérience, qui dure moins d’une seconde.La première méthode, appliquée au pavillon de Breteuil, à Sèvres, avec toutes les précautions habituelles au Bureau international des poids et mesures (Volet), a donné une précision de l’ordre du mGal. La seconde méthode a été pratiquée dans différents laboratoires, mais les résultats les plus précis paraissent être ceux du B.I.P.M. (S. Sakuma); la mesure interférentielle se fait directement entre le mobile et des repères fixes; la précision approcherait 0,01 mGal. L’appareil de Sakuma a été rendu mobile, et on a commencé, en France, à l’utiliser pour mesurer la valeur absolue de g en un certain nombre de stations, ce qui assurera la cohérence des réseaux; il apparaît que la valeur admise à Potsdam était trop forte de 13,6 mGal.Tous les appareils précédemment décrits exigent un support stable. Dans une mer peu profonde, il est possible de poser un gravimètre sur le fond, de le manœuvrer et de le lire par télécommande, avec une précision qui n’est guère inférieure à celle des mesures à terre.Felix Andries Vening Meinesz avait réalisé un système de pendules invariables, particulièrement bien protégés contre les déplacements du support. Conçu pour les sols instables de Hollande, il a pu être utilisé dans un sous-marin en plongée et a fourni une dizaine de milliers de mesures dans toutes les mers profondes du globe.Depuis le début des années soixante, des recherches approfondies ont permis l’emploi, sur un navire de surface, d’un gravimètre, qui doit être très fortement amorti, pour mesurer une valeur moyenne sur un temps long. La stabilisation en orientation de sa plate-forme et de multiples dispositifs destinés au calcul des corrections rendent la mesure très complexe, mais l’appareillage est maintenant opérationnel. Il pourrait être utilisé en avion, moyennant un contrôle serré de l’altitude. Cependant, toute mesure sur un véhicule en mouvement exige une correction pour tenir compte de la modification de la force centrifuge (de Coriolis). Pour un avion, la sensibilité cherchée (de l’ordre du mGal) exige la connaissance de cette vitesse avec une précision qui est à la limite de ce qui est réalisable.Lorsqu’il a été possible de mesurer la distance de la Terre à la Lune d’une manière précise, on en a déduit de manière simple une valeur précise de la gravité à l’équateur, qui s’est trouvée heureusement en assez bon accord avec la moyenne déduite des nombreuses stations terrestres. L’étude des satellites artificiels a également fourni des indications sur lesquelles nous reviendrons.3. L’exploitation des mesuresAnomalies à l’air libreMême un modèle assez grossier du globe terrestre, tel que celui de Alexis-Claude Clairaut (masse fluide en rotation, en équilibre sous l’action de sa propre attraction et de la force centrifuge), fait prévoir une variation de la gravité avec l’altitude et avec la latitude 﨏. Ces variations ont été vérifiées dès le XVIIe siècle, d’abord par la constatation du déréglage d’une horloge astronomique transportée à Cayenne (Jean Richer, 1673), ce qui était la première indication expérimentale en faveur de la théorie de l’attraction de Newton, puis par les travaux de P. Bouguer en Équateur. Comme ces variations, prévues par la théorie, ne nous apprennent plus rien, on a pris l’habitude d’en faire abstraction, en retranchant de la valeur mesurée la valeur théorique, en fonction de la latitude et de l’altitude, pour un ellipsoïde, choisi conventionnellement, dont les dimensions et l’aplatissement sont spécifiés. À la formule de 1924:

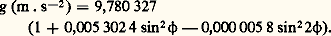

et dans la formule analogue pour le pendule composé. Au cours de sa célèbre expédition en Équateur, pour la mesure d’un arc de méridien, Pierre Bouguer a fait de nombreuses études sur la variation de g avec l’altitude et la latitude, en utilisant un pendule fait d’un corps suspendu à un fil dont il mesurait la longueur avec une règle. Mais la précision de ces mesures était faible. Elles ont été reprises par Charles de Borda, qui s’est efforcé de réaliser un pendule de forme connue (sphère suspendue à un fil). L’invention du pendule réversible a permis des résultats plus précis: si un pendule composé a la même période lorsqu’il oscille autour de deux axes parallèles convenablement disposés, on démontre que cette période est celle du pendule simple ayant pour longueur la distance des axes. On a pu obtenir ainsi une précision avoisinant le 1/100 000, mais non la dépasser (M. de Kaster, 1818; Friedrich Kühnen et Philipp Furtwängler, Potsdam, 1906).La comparaison de la période d’un pendule invariable avec l’heure transmise par radio a permis d’obtenir, moyennant des précautions sur lesquelles on n’insistera pas, une précision relative de l’ordre du 1/1 000 000. Il était alors possible de mesurer les différences de gravité entre deux points, avec une précision très supérieure à celle des mesures absolues. Pour assurer l’homogénéité du réseau des mesures, il a été décidé d’adopter conventionnellement la valeur mesurée à Potsdam et de mesurer, à partir de là, des différences de gravité.L’apparition des gravimètres, entre 1930 et 1940, a encore accentué les difficultés de cette situation. Un gravimètre est un système de ressorts et de masses mobiles, disposé de manière à se trouver à la limite de la stabilité, ce qui se traduit par une période d’oscillation très longue (par exemple, 6 secondes pour un dispositif de quelques centimètres). Il en résulte qu’une variation de g correspond à une déformation relativement importante, qu’un mode d’observation sensible peut mettre en évidence; le plus souvent, on annule cette déformation par un dispositif de compensation qui permet la mesure. Pour qu’une erreur de nivellement équivalente à l’action de forces horizontales soit sans effet, il faut que le déplacement de la masse se fasse suivant la verticale et que les points de suspension soient dans le plan horizontal du centre de masse de l’équipage mobile. Les effets thermiques sont corrigés par l’emploi de ressorts convenables (en quartz, en invar, ou bimétalliques) et, de plus, la plupart des gravimètres sont maintenus à température constante par un chauffage approprié, avec deux enceintes concentriques à des températures légèrement différentes. L’emploi de plusieurs masses de densités distinctes permet de corriger l’effet des variations de la densité de l’air sur la poussée d’Archimède. De nombreux gravimètres, assez rustiques pour être transportés avec un minimum de précautions, ont été réalisés suivant ces principes. Ils peuvent être mis en station et fournir une mesure en un temps de l’ordre de la minute. Cependant, ils ne donnent pas de mesures absolues, et les différences de gravité que décèlent leurs lectures doivent faire l’objet d’un étalonnage, entre des stations où la gravité est connue. Il faut aussi tenir compte d’une dérive, en gros proportionnelle au temps, en réoccupant périodiquement les mêmes stations. La sensibilité atteint 10-9, c’est-à-dire le microgal (g est de l’ordre de 981 Gal), la fidélité 0,1 mGal (1 Gal = 0,01 m . s-2).La facilité d’emploi des gravimètres a conduit à l’occupation de millions de stations qui constituent des réseaux localement très cohérents (à une fraction de mGal près), mais dont les calages relatifs paraissaient beaucoup moins assurés. On a repris, parallèlement, les liaisons à grande distance soit à l’aide de pendules invariables, soit par transport de gravimètres (entre stations où les valeurs de g sont très proches). On peut ainsi constituer un réseau mondial de bases, dont la cohérence est de l’ordre du mGal, et auquel tous les réseaux locaux devraient (théoriquement) être reliés. Ce travail de contrôle, exécuté en fait après coup, n’a pas mis en évidence de divergences trop graves entre les valeurs provisoirement admises.Les techniques de la physique ont accompli, entre-temps, des progrès considérables dans la mesure précise d’intervalles de temps très courts. Vers 1960, il est devenu possible d’envisager une mesure de g directe par l’étude de la chute libre d’un corps, au lieu d’employer la voie indirecte de son intégration dans le mouvement du pendule, voie qui s’était imposée depuis Galilée. Différents laboratoires ont entrepris des mesures «absolues» de g selon ce principe. Deux méthodes peuvent être envisagées. Ou bien on laisse tomber une règle divisée, et on la photographie à intervalles de temps connus en un point fixe. Ou bien on jette vers le haut un corps, et on chronomètre ses quatre passages en deux points dont la distance verticale est connue, en s’arrangeant pour mesurer directement cette distance, par un procédé interférentiel; bien entendu, l’expérience se fait dans le vide. La principale cause d’erreur est finalement constituée par les vibrations microsismiques des supports, mais rien n’empêche de répéter un grand nombre de fois l’expérience, qui dure moins d’une seconde.La première méthode, appliquée au pavillon de Breteuil, à Sèvres, avec toutes les précautions habituelles au Bureau international des poids et mesures (Volet), a donné une précision de l’ordre du mGal. La seconde méthode a été pratiquée dans différents laboratoires, mais les résultats les plus précis paraissent être ceux du B.I.P.M. (S. Sakuma); la mesure interférentielle se fait directement entre le mobile et des repères fixes; la précision approcherait 0,01 mGal. L’appareil de Sakuma a été rendu mobile, et on a commencé, en France, à l’utiliser pour mesurer la valeur absolue de g en un certain nombre de stations, ce qui assurera la cohérence des réseaux; il apparaît que la valeur admise à Potsdam était trop forte de 13,6 mGal.Tous les appareils précédemment décrits exigent un support stable. Dans une mer peu profonde, il est possible de poser un gravimètre sur le fond, de le manœuvrer et de le lire par télécommande, avec une précision qui n’est guère inférieure à celle des mesures à terre.Felix Andries Vening Meinesz avait réalisé un système de pendules invariables, particulièrement bien protégés contre les déplacements du support. Conçu pour les sols instables de Hollande, il a pu être utilisé dans un sous-marin en plongée et a fourni une dizaine de milliers de mesures dans toutes les mers profondes du globe.Depuis le début des années soixante, des recherches approfondies ont permis l’emploi, sur un navire de surface, d’un gravimètre, qui doit être très fortement amorti, pour mesurer une valeur moyenne sur un temps long. La stabilisation en orientation de sa plate-forme et de multiples dispositifs destinés au calcul des corrections rendent la mesure très complexe, mais l’appareillage est maintenant opérationnel. Il pourrait être utilisé en avion, moyennant un contrôle serré de l’altitude. Cependant, toute mesure sur un véhicule en mouvement exige une correction pour tenir compte de la modification de la force centrifuge (de Coriolis). Pour un avion, la sensibilité cherchée (de l’ordre du mGal) exige la connaissance de cette vitesse avec une précision qui est à la limite de ce qui est réalisable.Lorsqu’il a été possible de mesurer la distance de la Terre à la Lune d’une manière précise, on en a déduit de manière simple une valeur précise de la gravité à l’équateur, qui s’est trouvée heureusement en assez bon accord avec la moyenne déduite des nombreuses stations terrestres. L’étude des satellites artificiels a également fourni des indications sur lesquelles nous reviendrons.3. L’exploitation des mesuresAnomalies à l’air libreMême un modèle assez grossier du globe terrestre, tel que celui de Alexis-Claude Clairaut (masse fluide en rotation, en équilibre sous l’action de sa propre attraction et de la force centrifuge), fait prévoir une variation de la gravité avec l’altitude et avec la latitude 﨏. Ces variations ont été vérifiées dès le XVIIe siècle, d’abord par la constatation du déréglage d’une horloge astronomique transportée à Cayenne (Jean Richer, 1673), ce qui était la première indication expérimentale en faveur de la théorie de l’attraction de Newton, puis par les travaux de P. Bouguer en Équateur. Comme ces variations, prévues par la théorie, ne nous apprennent plus rien, on a pris l’habitude d’en faire abstraction, en retranchant de la valeur mesurée la valeur théorique, en fonction de la latitude et de l’altitude, pour un ellipsoïde, choisi conventionnellement, dont les dimensions et l’aplatissement sont spécifiés. À la formule de 1924: a succédé une formule qui tient compte de la valeur de l’aplatissement, fournie avec une grande précision par l’étude des satellites artificiels, ainsi que de la révision de la valeur de référence à Potsdam (valeur en 1993):

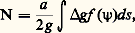

a succédé une formule qui tient compte de la valeur de l’aplatissement, fournie avec une grande précision par l’étude des satellites artificiels, ainsi que de la révision de la valeur de référence à Potsdam (valeur en 1993): Par ailleurs, la variation de la pesanteur avec l’altitude résulte directement de la théorie de la gravitation; elle est de 0,3074 mGal.m-1.À chaque station de mesure, de latitude et d’altitude connues, correspond donc une valeur théorique pour un globe conventionnel. La différence avec la valeur mesurée a reçu le nom, impropre, d’«anomalie» (il s’agit en réalité de la partie significative de la mesure, une fois soustraite de celle-ci l’effet de ce qui est connu).La comparaison directe, dont on vient d’indiquer le principe, fournit l’anomalie dite à l’«air libre» ou de «Faye». Le globe idéal de référence ayant été bien choisi, cette anomalie a une valeur moyenne pratiquement nulle. Sa valeur absolue est en général inférieure à 20 ou 30 mGal, sauf en région très accidentée.Anomalie de BouguerÀ l’échelle du kilomètre ou de la dizaine de kilomètres, l’anomalie à l’air libre présente cet inconvénient qu’elle ne tient aucun compte de la topographie, cependant bien connue dans sa forme sinon pour sa densité. Cela revient à comparer le globe réel à un globe limité à la surface de l’ellipsoïde. Or, il est évident que l’attraction de la part du relief doit intervenir dans les mesures.Pour en tenir compte, on définit une «anomalie de Bouguer», qui est la différence entre la mesure réelle et la valeur théorique au point correspondant, pour un modèle de Terre où l’ellipsoïde envisagé précédemment est complété par l’adjonction d’un relief «posé sur le géoïde comme un timbre-poste sur une enveloppe»; à ceci près qu’il faudrait, logiquement, y représenter les mers comme creusées sous la surface, et remplies par une matière ayant la densité de l’eau de mer.Si la densité attribuée au relief a été bien choisie, on constate que les valeurs de l’anomalie de Bouguer ne présentent pas de corrélation avec le relief local. On peut, en interpolant entre les stations de mesure, élaborer des cartes (par exemple au 1/20 000 ou au 1/50 000) où le tracé des courbes d’égale valeur de la composante verticale du champ de pesanteur (ou isogammes) ne présente plus aucune ressemblance avec les cartes du relief. Inversement, cela permet de choisir la valeur la plus représentative pour la densité du terrain. Ces cartes permettent l’interpolation entre les points de mesure, et également le calcul d’intégrales de surface, ou de valeurs moyennes.La «correction de Bouguer», qu’il faut ajouter à l’anomalie à l’air libre pour obtenir l’anomalie de Bouguer, exige le calcul de la composante verticale de l’attraction exercée, au point de station, par tout le relief situé au-dessus du niveau de la mer, et par le relief sous-marin, en attribuant au creux correspondant une densité négative, égale à la différence entre la densité de la roche et la densité de l’eau. Pour des raisons techniques, ce calcul se fait en deux étapes. On considère d’abord l’effet d’un plateau horizontal à l’altitude de la station; cet effet, proportionnel à l’altitude, est donné par 諸.0,04187 mGal.m -1; 諸 est la densité attribuée au terrain (pour 諸 = 2,67, l’effet est de 0,1118 mGal.m-1). Ensuite, on calcule l’effet (qui vient toujours en déduction du terme précédent) de la différence entre le relief réel et la surface du plateau, qui doit être considéré comme de densité négative si le relief est plus bas que la station. Ce dernier terme, ou «correction topographique», est souvent faible, parfois négligeable, mais son calcul, à partir des cartes topographiques, est relativement long malgré les aides dont on dispose (tables, abaques, ordinateurs, etc.).En principe, nous l’avons vu, on devrait, pour calculer l’anomalie de Bouguer, tenir compte du relief sous-marin. Mais, d’une part, celui-ci est souvent mal connu, et la tâche serait lourde. D’autre part, ce que l’on connaît en mer, c’est la valeur de la pesanteur à la surface de celle-ci. On préfère donc souvent définir une anomalie, qu’on peut appeler «anomalie pseudo-Bouguer», en n’effectuant pas la correction pour le relief sous-marin. On passe ainsi, en continuité pour les océans, à une «pseudo-anomalie à l’air libre» qui serait affectée par l’effet, faible et lointain, de la suppression du relief terrestre, que l’on s’abstient, en général, de calculer.De ce que nous avons dit de l’anomalie à l’air libre, en général faible et de signe quelconque, et de la valeur de la correction de Bouguer, il résulte que l’anomalie de Bouguer est négative, et parfois forte (100 à 150 mGal) dans les régions d’altitude élevée; elle serait positive et très forte dans une mer profonde. On en déduit que l’anomalie à l’air libre (ou l’anomalie pseudo-Bouguer) est positive et très forte (par exemple de 300 mGal) pour une île isolée en mer profonde. Le gravimétricien sait qu’il n’a pas à prendre en compte ces particularités, issues directement des définitions adoptées, dans son interprétation.Cette interprétation se fait toujours à partir des cartes de l’anomalie de Bouguer, et elle tend à fournir des informations sur la distribution des densités des roches au voisinage de la surface. Cependant, le problème ainsi posé reste largement indéterminé (en particulier, de toute solution, on peut en déduire d’autres, avec des contrastes de densité plus forts et des profondeurs moindres). Mais il est facile, si on se donne un modèle de distribution des densités en profondeur, de calculer la distribution de la gravité à la surface, et de la comparer à la distribution observée. Aussi procède-t-on par tâtonnements successifs, en tenant compte des informations dont on peut disposer par ailleurs, par la géologie ou par d’autres méthodes géophysiques.4. Applications à la géodésieL’écart entre la surface du géoïde et celle de l’ellipsoïde de référence, qui peut être de quelques dizaines de mètres, varie très progressivement et reste pratiquement constant sur des distances de quelques dizaines de kilomètres. Par conséquent, il n’est pas nécessaire, pour le déterminer, de tenir compte des irrégularités locales du relief. On n’utilise donc pas l’anomalie de Bouguer, mais l’anomalie à l’air libre, ou plutôt sa valeur moyenne, lissée sur quelques dizaines de kilomètres. Encore faut-il bien voir ce que signifie cette moyenne, qui n’est pas la moyenne des valeurs mesurées aux stations (il peut arriver que la majorité de celles-ci soient au fond des vallées), mais la moyenne de sa valeur en tous points. Comme on ne peut pas en tracer de cartes, il faudrait prendre la moyenne de l’anomalie de Bouguer, à partir de ses cartes, et calculer la valeur moyenne de la correction de Bouguer, ce qui fait intervenir l’altitude moyenne à déduire des cartes topographiques.Le géoïde que nous cherchons à déterminer étant une surface équipotentielle du champ extérieur de la pesanteur, éventuellement prolongé sous le relief, il est normal d’utiliser pour cette détermination les anomalies à l’air libre, qui caractérisent le champ extérieur. En particulier, ce sont les valeurs de l’anomalie à l’air libre au niveau de la mer qui avaient permis de déterminer l’aplatissement du globe, dans le cadre fourni par les formules de Clairaut, valables pour une masse fluide en rotation (en fait, concurremment avec les valeurs déduites des méthodes géométriques de la géodésie).La possibilité d’aller plus loin pour déterminer, à partir des valeurs de la gravité, la forme de la Terre ou, plus précisément, la forme de l’une des surfaces équipotentielles de la pesanteur résulte de la formule de Stokes, établie en 1849. On réfère la surface équipotentielle cherchée, ou géoïde, à l’ellipsoïde qui constituerait la surface équipotentielle d’un globe idéal de Clairaut. Si N est la distance verticale entre ces deux surfaces en un point, et g la différence entre les valeurs de la gravité mesurée au niveau de l’équipotentielle et calculée sur l’ellipsoïde, en un autre point, situé à une distance angulaire 祥 du premier, on a:

Par ailleurs, la variation de la pesanteur avec l’altitude résulte directement de la théorie de la gravitation; elle est de 0,3074 mGal.m-1.À chaque station de mesure, de latitude et d’altitude connues, correspond donc une valeur théorique pour un globe conventionnel. La différence avec la valeur mesurée a reçu le nom, impropre, d’«anomalie» (il s’agit en réalité de la partie significative de la mesure, une fois soustraite de celle-ci l’effet de ce qui est connu).La comparaison directe, dont on vient d’indiquer le principe, fournit l’anomalie dite à l’«air libre» ou de «Faye». Le globe idéal de référence ayant été bien choisi, cette anomalie a une valeur moyenne pratiquement nulle. Sa valeur absolue est en général inférieure à 20 ou 30 mGal, sauf en région très accidentée.Anomalie de BouguerÀ l’échelle du kilomètre ou de la dizaine de kilomètres, l’anomalie à l’air libre présente cet inconvénient qu’elle ne tient aucun compte de la topographie, cependant bien connue dans sa forme sinon pour sa densité. Cela revient à comparer le globe réel à un globe limité à la surface de l’ellipsoïde. Or, il est évident que l’attraction de la part du relief doit intervenir dans les mesures.Pour en tenir compte, on définit une «anomalie de Bouguer», qui est la différence entre la mesure réelle et la valeur théorique au point correspondant, pour un modèle de Terre où l’ellipsoïde envisagé précédemment est complété par l’adjonction d’un relief «posé sur le géoïde comme un timbre-poste sur une enveloppe»; à ceci près qu’il faudrait, logiquement, y représenter les mers comme creusées sous la surface, et remplies par une matière ayant la densité de l’eau de mer.Si la densité attribuée au relief a été bien choisie, on constate que les valeurs de l’anomalie de Bouguer ne présentent pas de corrélation avec le relief local. On peut, en interpolant entre les stations de mesure, élaborer des cartes (par exemple au 1/20 000 ou au 1/50 000) où le tracé des courbes d’égale valeur de la composante verticale du champ de pesanteur (ou isogammes) ne présente plus aucune ressemblance avec les cartes du relief. Inversement, cela permet de choisir la valeur la plus représentative pour la densité du terrain. Ces cartes permettent l’interpolation entre les points de mesure, et également le calcul d’intégrales de surface, ou de valeurs moyennes.La «correction de Bouguer», qu’il faut ajouter à l’anomalie à l’air libre pour obtenir l’anomalie de Bouguer, exige le calcul de la composante verticale de l’attraction exercée, au point de station, par tout le relief situé au-dessus du niveau de la mer, et par le relief sous-marin, en attribuant au creux correspondant une densité négative, égale à la différence entre la densité de la roche et la densité de l’eau. Pour des raisons techniques, ce calcul se fait en deux étapes. On considère d’abord l’effet d’un plateau horizontal à l’altitude de la station; cet effet, proportionnel à l’altitude, est donné par 諸.0,04187 mGal.m -1; 諸 est la densité attribuée au terrain (pour 諸 = 2,67, l’effet est de 0,1118 mGal.m-1). Ensuite, on calcule l’effet (qui vient toujours en déduction du terme précédent) de la différence entre le relief réel et la surface du plateau, qui doit être considéré comme de densité négative si le relief est plus bas que la station. Ce dernier terme, ou «correction topographique», est souvent faible, parfois négligeable, mais son calcul, à partir des cartes topographiques, est relativement long malgré les aides dont on dispose (tables, abaques, ordinateurs, etc.).En principe, nous l’avons vu, on devrait, pour calculer l’anomalie de Bouguer, tenir compte du relief sous-marin. Mais, d’une part, celui-ci est souvent mal connu, et la tâche serait lourde. D’autre part, ce que l’on connaît en mer, c’est la valeur de la pesanteur à la surface de celle-ci. On préfère donc souvent définir une anomalie, qu’on peut appeler «anomalie pseudo-Bouguer», en n’effectuant pas la correction pour le relief sous-marin. On passe ainsi, en continuité pour les océans, à une «pseudo-anomalie à l’air libre» qui serait affectée par l’effet, faible et lointain, de la suppression du relief terrestre, que l’on s’abstient, en général, de calculer.De ce que nous avons dit de l’anomalie à l’air libre, en général faible et de signe quelconque, et de la valeur de la correction de Bouguer, il résulte que l’anomalie de Bouguer est négative, et parfois forte (100 à 150 mGal) dans les régions d’altitude élevée; elle serait positive et très forte dans une mer profonde. On en déduit que l’anomalie à l’air libre (ou l’anomalie pseudo-Bouguer) est positive et très forte (par exemple de 300 mGal) pour une île isolée en mer profonde. Le gravimétricien sait qu’il n’a pas à prendre en compte ces particularités, issues directement des définitions adoptées, dans son interprétation.Cette interprétation se fait toujours à partir des cartes de l’anomalie de Bouguer, et elle tend à fournir des informations sur la distribution des densités des roches au voisinage de la surface. Cependant, le problème ainsi posé reste largement indéterminé (en particulier, de toute solution, on peut en déduire d’autres, avec des contrastes de densité plus forts et des profondeurs moindres). Mais il est facile, si on se donne un modèle de distribution des densités en profondeur, de calculer la distribution de la gravité à la surface, et de la comparer à la distribution observée. Aussi procède-t-on par tâtonnements successifs, en tenant compte des informations dont on peut disposer par ailleurs, par la géologie ou par d’autres méthodes géophysiques.4. Applications à la géodésieL’écart entre la surface du géoïde et celle de l’ellipsoïde de référence, qui peut être de quelques dizaines de mètres, varie très progressivement et reste pratiquement constant sur des distances de quelques dizaines de kilomètres. Par conséquent, il n’est pas nécessaire, pour le déterminer, de tenir compte des irrégularités locales du relief. On n’utilise donc pas l’anomalie de Bouguer, mais l’anomalie à l’air libre, ou plutôt sa valeur moyenne, lissée sur quelques dizaines de kilomètres. Encore faut-il bien voir ce que signifie cette moyenne, qui n’est pas la moyenne des valeurs mesurées aux stations (il peut arriver que la majorité de celles-ci soient au fond des vallées), mais la moyenne de sa valeur en tous points. Comme on ne peut pas en tracer de cartes, il faudrait prendre la moyenne de l’anomalie de Bouguer, à partir de ses cartes, et calculer la valeur moyenne de la correction de Bouguer, ce qui fait intervenir l’altitude moyenne à déduire des cartes topographiques.Le géoïde que nous cherchons à déterminer étant une surface équipotentielle du champ extérieur de la pesanteur, éventuellement prolongé sous le relief, il est normal d’utiliser pour cette détermination les anomalies à l’air libre, qui caractérisent le champ extérieur. En particulier, ce sont les valeurs de l’anomalie à l’air libre au niveau de la mer qui avaient permis de déterminer l’aplatissement du globe, dans le cadre fourni par les formules de Clairaut, valables pour une masse fluide en rotation (en fait, concurremment avec les valeurs déduites des méthodes géométriques de la géodésie).La possibilité d’aller plus loin pour déterminer, à partir des valeurs de la gravité, la forme de la Terre ou, plus précisément, la forme de l’une des surfaces équipotentielles de la pesanteur résulte de la formule de Stokes, établie en 1849. On réfère la surface équipotentielle cherchée, ou géoïde, à l’ellipsoïde qui constituerait la surface équipotentielle d’un globe idéal de Clairaut. Si N est la distance verticale entre ces deux surfaces en un point, et g la différence entre les valeurs de la gravité mesurée au niveau de l’équipotentielle et calculée sur l’ellipsoïde, en un autre point, situé à une distance angulaire 祥 du premier, on a: l’intégrale étant étendue à toute la surface du globe. La fonction f ( 祥), qui est bien déterminée, n’est nulle part négligeable.Il faut, bien entendu, que les surfaces équipotentielles considérées soient entièrement extérieures à la matière du globe, ce qui n’est pas le cas pour le niveau moyen des mers. Mais on a démontré que la formule restait valable pour l’anomalie à l’air libre, mesurée à la surface.La formule de Stokes est restée pratiquement inutilisable pendant un siècle: on manquait de mesures de la gravité sur une grande partie de la surface, en particulier pour toutes les zones océaniques.Des applications à des régions limitées à quelques milliers de kilomètres ont fourni des cartes des irrégularités locales du géoïde avec un très grand détail. Les doutes que laissent subsister les approximations dont il a fallu se contenter pour représenter les valeurs de la pesanteur pour certaines zones lointaines se traduisent par un doute sur le niveau exact par rapport au centre de la Terre. Mais la géodésie spatiale a pris le relais.F. A. Vening Meinesz a montré que l’on pouvait dériver la formule de Stokes et en déduire, non plus la distance d’une surface équipotentielle à l’ellipsoïde de référence, mais l’angle que font les deux normales. Dans les formules dérivées (une pour la composante est-ouest et l’autre pour la composante nord-sud), les zones loin du centre n’ont presque plus d’influence, mais il faut connaître avec beaucoup de précision la gravité dans une zone très proche, ce qui est facilement réalisable.Par définition, le centre de l’ellipsoïde de référence coïncide avec le centre de masse du globe réel. Or, lorsqu’on calcule une triangulation sur un ellipsoïde [cf. GÉODÉSIE], un choix arbitraire intervient dans la manière de situer cet ellipsoïde de référence, en décidant de la coïncidence de sa normale avec la verticale en un point (au Panthéon pour la France). L’application des formules de F. A. Vening Meinesz fournit une solution beaucoup plus logique, qui n’a guère été employée parce qu’elle est arrivée trop tard.5. L’isostasieDans l’application de la formule de Stokes, et dans toutes les applications géodésiques, il faut évidemment considérer le champ de la pesanteur à l’extérieur de la Terre, qui est caractérisé par les valeurs de l’anomalie à l’air libre. Or, on a vu que l’anomalie à l’air libre ne se prête pas à l’interpolation entre stations, ce qui rend difficile le calcul de son intégrale. Il aurait été possible de s’en tirer en introduisant systématiquement l’«altitude moyenne régionale». Mais, historiquement, on a procédé d’une manière un peu différente, pratiquement équivalente, en se fondant sur l’isostasie.Le fait que l’anomalie à l’air libre soit faible et de signe quelconque revient à dire que le champ de gravité de la Terre, vu à une altitude de 20 ou 100 km, serait assez régulier et ne présenterait pas de corrélation avec le relief, même si l’on considère le contraste entre les blocs continentaux et les océans. Comme le relief existe cependant, il faut que son effet soit compensé, et ce ne peut être que par des fluctuations de densité, à une profondeur de quelques dizaines de kilomètres au plus. Ce fait de la compensation a été amplement vérifié, depuis sa mise en évidence dans l’Him laya par John Henry Pratt en 1855. Il appelle une interprétation mécanique, proposée par George Biddell Airy la même année: cette compensation pourrait résulter de ce qu’une écorce, douée de rigidité, irrégulière dans sa densité, sa composition, son épaisseur, repose en équilibre hydrostatique – c’est-à-dire flotte – sur un magma profond fluide. On a donné le nom d’isostasie à cette hypothèse, dont la suite logique est que cet équilibre peut se réajuster, s’il est troublé, à une vitesse qui reste à déterminer et qui dépend, notamment, de la viscosité du magma fluide profond; des observations géologiques, portant en particulier sur le soulèvement postglaciaire de la Scandinavie, ont permis d’estimer cette vitesse [cf. ÉPEIROGENÈSE].Depuis les travaux de John Fillmore Hayford, c’est-à-dire depuis les dernières années du XIXe siècle, les géodésiens ont fait appel à l’isostasie pour surmonter la difficulté qu’il y avait à intégrer l’anomalie à l’air libre.Il faut imaginer pour cela un modèle définissant la position exacte des densités compensatrices, en fonction du seul relief. Un tel modèle – on en a proposé plus d’une douzaine, parmi lesquels ceux de Hayford, de Airy-Heiskanen, de F. A. Vening Meinesz, pour ne citer que les plus connus – est nécessairement très arbitraire. À l’anomalie à l’air libre, on fait subir une «correction isostatique», qui est la somme de la correction de Bouguer (effet de la suppression du relief, jusqu’au niveau de la mer) et de la suppression des densités compensatrices situées en profondeur. Le calcul de cette correction implique une intégration numérique, définie par des tables à partir du seul relief. L’anomalie isostatique ainsi obtenue serait très faible si le modèle correspondait à la réalité. On peut, en tout cas, l’utiliser dans la formule de Stokes; on montre que le caractère arbitraire des modèles utilisés ne doit pas avoir d’influence sur le résultat, si l’on prend soin de calculer aussi la déformation de la surface équipotentielle produite par les modifications apportées au globe (effet indirect). Il ne s’agit donc que d’un artifice de calcul, inutilement compliqué, et dont l’utilisation paraît décroître.Mais il ne faut pas confondre cette utilisation pour le calcul, qui exigeait la définition précise de modèles conventionnels, et le fait physique de la réalité d’un équilibre isostatique, que confirment amplement les valeurs relativement faibles de l’anomalie à l’air libre. Il semble bien qu’il faille aujourd’hui considérer cet équilibre isostatique comme une loi générale – sous la réserve qu’il existe des zones où cet équilibre est en cours de rétablissement –, mais en considérant que l’écorce qui est en équilibre hydrostatique peut être de structure, de densité, d’épaisseur et de rigidité assez variables, selon les lieux, aucun des modèles proposés par les géodésiens n’en donnant une représentation satisfaisante.En particulier, les zones dites d’«anomalies isostatiques», que l’on trouve à l’extérieur des arcs insulaires du Pacifique (zones de subduction, dites de «Benioff»), ou, plus près de nous, dans la plaine du Pô (avec des amplitudes négatives de 100 à 200 mGal), sont des zones où l’équilibre hydrostatique intéresse une bande très large (500 km), à la structure complexe, dans laquelle des phénomènes dynamiques entraînent en profondeur des terrains relativement légers, au sein d’une écorce qui n’est que globalement en équilibre.Quant aux irrégularités du géoïde, dont les dimensions sont de plusieurs milliers de kilomètres (et l’amplitude de quelques dizaines de mètres seulement), leur interprétation physique la plus vraisemblable fait appel à des fluctuations de densité, d’ailleurs faibles (ordre de grandeur: 0,01), dans le manteau, c’est-à-dire à des profondeurs comprises entre 100 et 2 860 km; ces écarts au modèle idéal de Clairaut (formé de couches concentriques en équilibre, chacune de densité uniforme) correspondent à des phénomènes dynamiques, tels que des courants de convection, extrêmement lents (période de l’ordre de la centaine de millions d’années), mais qui sont à l’origine de l’énergie dissipée par la géodynamique interne (tectonique, dérive des plaques, etc.).L’équilibre isostatique, dont la réalité est établie par la gravimétrie – en même temps que celle-ci permet de mettre en évidence les irrégularités du matériel auquel s’applique cet équilibre –, constitue le cadre permanent dans lequel se situent ces phénomènes dynamiques.6. L’utilisation des satellitesLa mesure directe de la forme de la surface des mersCertains satellites (G.E.O.S.-3, Seasat, Geosat, E.R.S.-1, Topex-Poseidon...) ont été munis d’un radar mesurant à quelques décimètres ou centimètres près leur distance au niveau de la mer. Toutes corrections de trajectoires faites, ces satellites fournissent une information sur la forme de détail du géoïde dans ses zones marines (cf. carte ci-dessus et hors-texte de l’article océan PACIFIQUE), qui complète en fait les données gravimétriques (beaucoup plus nombreuses et fiables à terre que dans l’étendue des océans), bien qu’elle soit d’une nature très différente. Le Bureau gravimétrique international, qui avait été institué pour faciliter la diffusion des millions de mesures gravimétriques existantes en vue de l’exploitation globale nécessitée par la géodésie, a été réorganisé pour prendre également en charge ces données sur l’altimétrie du géoïde, et étudier la manière de les combiner.L’interprétation des trajectoires observéesL’étude des satellites artificiels proches de la Terre a conduit à reposer le problème de l’étude du champ de gravité de la Terre en des termes nouveaux. Leur mouvement est profondément influencé par le fait que la Terre n’est pas une sphère homogène; les éléments caractéristiques de l’orbite keplérienne (plan de l’orbite, direction et grandeur du grand axe, excentricité) se modifient constamment, au lieu de rester fixes, comme dans le cas où la Terre serait sphérique.Pour étudier leurs variations, on est conduit à développer le potentiel de la gravitation en une série de termes «harmoniques sphériques», dont chacun comporte une fonction déterminée de la latitude et de la longitude, multipliée par une puissance négative de la distance au centre et par un coefficient a priori inconnu. Si on connaît les perturbations subies par un nombre élevé de satellites ayant des orbites très différentes (en inclinaison et excentricité), on peut déterminer un certain nombre de ces coefficients. Pour les termes qui sont fonction de la longitude, il faut, à cause de la rotation de la Terre, pratiquement faire appel aux satellites géostationnaires, c’est-à-dire dont la durée de révolution est un jour, satellites dont le rôle en télécommunication est particulièrement important. On connaît maintenant un assez grand nombre de ces coefficients; le deuxième correspond à l’aplatissement, qui se trouve aussi déterminé d’une manière très précise (1/298,257...).Le développement harmonique est aujourd’hui connu jusqu’aux termes d’ordre atteignant 30, ce qui implique la connaissance de plusieurs centaines de coefficients. Il est très facile d’en déduire, sous la même forme d’un développement en série harmonique, la forme du géoïde, rapportée à l’ellipsoïde, ou la valeur de la pesanteur à son niveau, c’est-à-dire l’anomalie à l’air libre. Mais cette forme du géoïde, si elle est très sûre, se trouve lissée et débarrassée de toutes les irrégularités de largeur inférieure à 1 000 ou 2 000 km.Il est possible, et c’est la tâche de l’avenir, de combiner la représentation du géoïde, ainsi déduite de l’étude des orbites des satellites, avec les indications, complémentaires et localement beaucoup plus fines, que peut fournir la gravimétrie. Il faudra pour cela appliquer la formule de Stokes, pour calculer l’écart entre le géoïde et sa représentation par une série harmonique, à partir de l’écart entre les anomalies à l’air libre mesurées et celles déduites du même développement harmonique du potentiel.En mer, où les valeurs de la pesanteur sont beaucoup moins nombreuses et moins sûres qu’à terre, il est préférable d’utiliser les profils fournis par les satellites à radar altimétrique cités et leurs successeurs, par exemple, G.R.M. (Geopotential Research Mission ) qui donnent la forme du géoïde matérialisé par la surface de la mer. Encore faudra-t-il assurer le raccordement de ces deux types de solutions.D’une manière ou d’une autre, le problème fondamental de la géodésie, qui est de déterminer la forme du géoïde, peut être considéré comme résolu; mais une précision meilleure que le décimètre, qui est aujourd’hui atteinte, implique toujours l’utilisation de la gravimétrie pour accéder aux irrégularités locales.

l’intégrale étant étendue à toute la surface du globe. La fonction f ( 祥), qui est bien déterminée, n’est nulle part négligeable.Il faut, bien entendu, que les surfaces équipotentielles considérées soient entièrement extérieures à la matière du globe, ce qui n’est pas le cas pour le niveau moyen des mers. Mais on a démontré que la formule restait valable pour l’anomalie à l’air libre, mesurée à la surface.La formule de Stokes est restée pratiquement inutilisable pendant un siècle: on manquait de mesures de la gravité sur une grande partie de la surface, en particulier pour toutes les zones océaniques.Des applications à des régions limitées à quelques milliers de kilomètres ont fourni des cartes des irrégularités locales du géoïde avec un très grand détail. Les doutes que laissent subsister les approximations dont il a fallu se contenter pour représenter les valeurs de la pesanteur pour certaines zones lointaines se traduisent par un doute sur le niveau exact par rapport au centre de la Terre. Mais la géodésie spatiale a pris le relais.F. A. Vening Meinesz a montré que l’on pouvait dériver la formule de Stokes et en déduire, non plus la distance d’une surface équipotentielle à l’ellipsoïde de référence, mais l’angle que font les deux normales. Dans les formules dérivées (une pour la composante est-ouest et l’autre pour la composante nord-sud), les zones loin du centre n’ont presque plus d’influence, mais il faut connaître avec beaucoup de précision la gravité dans une zone très proche, ce qui est facilement réalisable.Par définition, le centre de l’ellipsoïde de référence coïncide avec le centre de masse du globe réel. Or, lorsqu’on calcule une triangulation sur un ellipsoïde [cf. GÉODÉSIE], un choix arbitraire intervient dans la manière de situer cet ellipsoïde de référence, en décidant de la coïncidence de sa normale avec la verticale en un point (au Panthéon pour la France). L’application des formules de F. A. Vening Meinesz fournit une solution beaucoup plus logique, qui n’a guère été employée parce qu’elle est arrivée trop tard.5. L’isostasieDans l’application de la formule de Stokes, et dans toutes les applications géodésiques, il faut évidemment considérer le champ de la pesanteur à l’extérieur de la Terre, qui est caractérisé par les valeurs de l’anomalie à l’air libre. Or, on a vu que l’anomalie à l’air libre ne se prête pas à l’interpolation entre stations, ce qui rend difficile le calcul de son intégrale. Il aurait été possible de s’en tirer en introduisant systématiquement l’«altitude moyenne régionale». Mais, historiquement, on a procédé d’une manière un peu différente, pratiquement équivalente, en se fondant sur l’isostasie.Le fait que l’anomalie à l’air libre soit faible et de signe quelconque revient à dire que le champ de gravité de la Terre, vu à une altitude de 20 ou 100 km, serait assez régulier et ne présenterait pas de corrélation avec le relief, même si l’on considère le contraste entre les blocs continentaux et les océans. Comme le relief existe cependant, il faut que son effet soit compensé, et ce ne peut être que par des fluctuations de densité, à une profondeur de quelques dizaines de kilomètres au plus. Ce fait de la compensation a été amplement vérifié, depuis sa mise en évidence dans l’Him laya par John Henry Pratt en 1855. Il appelle une interprétation mécanique, proposée par George Biddell Airy la même année: cette compensation pourrait résulter de ce qu’une écorce, douée de rigidité, irrégulière dans sa densité, sa composition, son épaisseur, repose en équilibre hydrostatique – c’est-à-dire flotte – sur un magma profond fluide. On a donné le nom d’isostasie à cette hypothèse, dont la suite logique est que cet équilibre peut se réajuster, s’il est troublé, à une vitesse qui reste à déterminer et qui dépend, notamment, de la viscosité du magma fluide profond; des observations géologiques, portant en particulier sur le soulèvement postglaciaire de la Scandinavie, ont permis d’estimer cette vitesse [cf. ÉPEIROGENÈSE].Depuis les travaux de John Fillmore Hayford, c’est-à-dire depuis les dernières années du XIXe siècle, les géodésiens ont fait appel à l’isostasie pour surmonter la difficulté qu’il y avait à intégrer l’anomalie à l’air libre.Il faut imaginer pour cela un modèle définissant la position exacte des densités compensatrices, en fonction du seul relief. Un tel modèle – on en a proposé plus d’une douzaine, parmi lesquels ceux de Hayford, de Airy-Heiskanen, de F. A. Vening Meinesz, pour ne citer que les plus connus – est nécessairement très arbitraire. À l’anomalie à l’air libre, on fait subir une «correction isostatique», qui est la somme de la correction de Bouguer (effet de la suppression du relief, jusqu’au niveau de la mer) et de la suppression des densités compensatrices situées en profondeur. Le calcul de cette correction implique une intégration numérique, définie par des tables à partir du seul relief. L’anomalie isostatique ainsi obtenue serait très faible si le modèle correspondait à la réalité. On peut, en tout cas, l’utiliser dans la formule de Stokes; on montre que le caractère arbitraire des modèles utilisés ne doit pas avoir d’influence sur le résultat, si l’on prend soin de calculer aussi la déformation de la surface équipotentielle produite par les modifications apportées au globe (effet indirect). Il ne s’agit donc que d’un artifice de calcul, inutilement compliqué, et dont l’utilisation paraît décroître.Mais il ne faut pas confondre cette utilisation pour le calcul, qui exigeait la définition précise de modèles conventionnels, et le fait physique de la réalité d’un équilibre isostatique, que confirment amplement les valeurs relativement faibles de l’anomalie à l’air libre. Il semble bien qu’il faille aujourd’hui considérer cet équilibre isostatique comme une loi générale – sous la réserve qu’il existe des zones où cet équilibre est en cours de rétablissement –, mais en considérant que l’écorce qui est en équilibre hydrostatique peut être de structure, de densité, d’épaisseur et de rigidité assez variables, selon les lieux, aucun des modèles proposés par les géodésiens n’en donnant une représentation satisfaisante.En particulier, les zones dites d’«anomalies isostatiques», que l’on trouve à l’extérieur des arcs insulaires du Pacifique (zones de subduction, dites de «Benioff»), ou, plus près de nous, dans la plaine du Pô (avec des amplitudes négatives de 100 à 200 mGal), sont des zones où l’équilibre hydrostatique intéresse une bande très large (500 km), à la structure complexe, dans laquelle des phénomènes dynamiques entraînent en profondeur des terrains relativement légers, au sein d’une écorce qui n’est que globalement en équilibre.Quant aux irrégularités du géoïde, dont les dimensions sont de plusieurs milliers de kilomètres (et l’amplitude de quelques dizaines de mètres seulement), leur interprétation physique la plus vraisemblable fait appel à des fluctuations de densité, d’ailleurs faibles (ordre de grandeur: 0,01), dans le manteau, c’est-à-dire à des profondeurs comprises entre 100 et 2 860 km; ces écarts au modèle idéal de Clairaut (formé de couches concentriques en équilibre, chacune de densité uniforme) correspondent à des phénomènes dynamiques, tels que des courants de convection, extrêmement lents (période de l’ordre de la centaine de millions d’années), mais qui sont à l’origine de l’énergie dissipée par la géodynamique interne (tectonique, dérive des plaques, etc.).L’équilibre isostatique, dont la réalité est établie par la gravimétrie – en même temps que celle-ci permet de mettre en évidence les irrégularités du matériel auquel s’applique cet équilibre –, constitue le cadre permanent dans lequel se situent ces phénomènes dynamiques.6. L’utilisation des satellitesLa mesure directe de la forme de la surface des mersCertains satellites (G.E.O.S.-3, Seasat, Geosat, E.R.S.-1, Topex-Poseidon...) ont été munis d’un radar mesurant à quelques décimètres ou centimètres près leur distance au niveau de la mer. Toutes corrections de trajectoires faites, ces satellites fournissent une information sur la forme de détail du géoïde dans ses zones marines (cf. carte ci-dessus et hors-texte de l’article océan PACIFIQUE), qui complète en fait les données gravimétriques (beaucoup plus nombreuses et fiables à terre que dans l’étendue des océans), bien qu’elle soit d’une nature très différente. Le Bureau gravimétrique international, qui avait été institué pour faciliter la diffusion des millions de mesures gravimétriques existantes en vue de l’exploitation globale nécessitée par la géodésie, a été réorganisé pour prendre également en charge ces données sur l’altimétrie du géoïde, et étudier la manière de les combiner.L’interprétation des trajectoires observéesL’étude des satellites artificiels proches de la Terre a conduit à reposer le problème de l’étude du champ de gravité de la Terre en des termes nouveaux. Leur mouvement est profondément influencé par le fait que la Terre n’est pas une sphère homogène; les éléments caractéristiques de l’orbite keplérienne (plan de l’orbite, direction et grandeur du grand axe, excentricité) se modifient constamment, au lieu de rester fixes, comme dans le cas où la Terre serait sphérique.Pour étudier leurs variations, on est conduit à développer le potentiel de la gravitation en une série de termes «harmoniques sphériques», dont chacun comporte une fonction déterminée de la latitude et de la longitude, multipliée par une puissance négative de la distance au centre et par un coefficient a priori inconnu. Si on connaît les perturbations subies par un nombre élevé de satellites ayant des orbites très différentes (en inclinaison et excentricité), on peut déterminer un certain nombre de ces coefficients. Pour les termes qui sont fonction de la longitude, il faut, à cause de la rotation de la Terre, pratiquement faire appel aux satellites géostationnaires, c’est-à-dire dont la durée de révolution est un jour, satellites dont le rôle en télécommunication est particulièrement important. On connaît maintenant un assez grand nombre de ces coefficients; le deuxième correspond à l’aplatissement, qui se trouve aussi déterminé d’une manière très précise (1/298,257...).Le développement harmonique est aujourd’hui connu jusqu’aux termes d’ordre atteignant 30, ce qui implique la connaissance de plusieurs centaines de coefficients. Il est très facile d’en déduire, sous la même forme d’un développement en série harmonique, la forme du géoïde, rapportée à l’ellipsoïde, ou la valeur de la pesanteur à son niveau, c’est-à-dire l’anomalie à l’air libre. Mais cette forme du géoïde, si elle est très sûre, se trouve lissée et débarrassée de toutes les irrégularités de largeur inférieure à 1 000 ou 2 000 km.Il est possible, et c’est la tâche de l’avenir, de combiner la représentation du géoïde, ainsi déduite de l’étude des orbites des satellites, avec les indications, complémentaires et localement beaucoup plus fines, que peut fournir la gravimétrie. Il faudra pour cela appliquer la formule de Stokes, pour calculer l’écart entre le géoïde et sa représentation par une série harmonique, à partir de l’écart entre les anomalies à l’air libre mesurées et celles déduites du même développement harmonique du potentiel.En mer, où les valeurs de la pesanteur sont beaucoup moins nombreuses et moins sûres qu’à terre, il est préférable d’utiliser les profils fournis par les satellites à radar altimétrique cités et leurs successeurs, par exemple, G.R.M. (Geopotential Research Mission ) qui donnent la forme du géoïde matérialisé par la surface de la mer. Encore faudra-t-il assurer le raccordement de ces deux types de solutions.D’une manière ou d’une autre, le problème fondamental de la géodésie, qui est de déterminer la forme du géoïde, peut être considéré comme résolu; mais une précision meilleure que le décimètre, qui est aujourd’hui atteinte, implique toujours l’utilisation de la gravimétrie pour accéder aux irrégularités locales.

gravimétrie [ gravimetri ] n. f.• 1904; du lat. gravis et -métrie♦ Phys. Mesure de l'intensité de la pesanteur. — Chim. Analyse par pesées. — Adj. GRAVIMÉTRIQUE .

● gravimétrie nom féminin Mesure de la pesanteur, appliquée à la connaissance de la forme et de la structure de la Terre. Analyse chimique quantitative effectuée par pesées. Technique physique de séparation des minerais en fonction de leur densité. (Elle est utilisée efficacement pour des particules de plus de 100 μm présentant un contraste suffisant de densité.)gravimétrien. f.d1./d PHYS Mesure de l'intensité du champ de la pesanteur.d2./d CHIM Méthode d'analyse par pesée d'un précipité.⇒GRAVIMÉTRIE, subst. fém.A. — PHYS. Étude, mesure de l'intensité de la pesanteur. Ce que nous savons par les résultats de la séismologie et de la gravimétrie, c'est que notre globe est formé de zones concentriques entre lesquelles on observe ce que l'on appelle les « discontinuités » (Ch. COMBALUZIER, Introd. à la géol., 1961, p. 60).— P. méton. Méthode d'exploration géophysique ou géodésique fondée sur cette mesure. Pour déterminer les lois normales de variation de g [intensité de la pesanteur] avec la latitude et l'altitude, la gravimétrie est inséparable des autres méthodes de la géodésie (Encyclop. univ. t. 7 1968, p. 980b).B. — CHIM. Méthode d'analyse quantitative par pesée. L'instrument essentiel pour réaliser une gravimétrie est la balance au 1/10 ou au 1/100 ou au 1/1000 de milligramme qu'est venu compléter depuis une vingtaine d'années un autre appareil indispensable appelé thermobalance (Encyclop. Sc. Techn., t. 6, 1971, p. 458).Prononc. : [ ]. Étymol. et Hist. 1922 (Lar. univ.). Dér. sav. du lat. gravis « lourd », v. grave; élém. -métrie (-mètre + -ie); cf. l'angl. gravimetry (1873 ds NED).DÉR. Gravimétrique, adj. a) Qui concerne, qui appartient à la gravimétrie (supra A). Carte, exploration gravimétrique. La balance de torsion gravimétrique de Leotvos (1895) a été aussi appliquée avec succès aux mesures gravimétriques relatives et à la prospection pétrolière (Hist. gén. sc., t. 3, vol. 2, 1964, p. 454). b) Qui fait intervenir la pesanteur (cf. Minéral. 1972). Pour les séparations gravimétriques, on a généralisé l'emploi de liqueurs lourdes variées et préconisé dans certains cas la centrifugation (Hist. gén. sc., t. 3, vol. 2, p. 483). c) Qui fait intervenir une pesée. Dosage, mesure gravimétrique. Des procédés gravimétriques et volumétriques satisfaisants étaient utilisables pour l'analyse de nombreuses substances minérales (Hist. gén. sc., t. 3, vol. 2p. 413). Il y a lieu de (...) distinguer [la densité réelle] de la densité gravimétrique, que l'on obtient en pesant un certain volume de poudre non tassée, c'est-à-dire sans tenir compte des vides existant entre les grains (LEDIEU, CADIAT, Nouv. matér. nav., 1890, p. 36). — [

]. Étymol. et Hist. 1922 (Lar. univ.). Dér. sav. du lat. gravis « lourd », v. grave; élém. -métrie (-mètre + -ie); cf. l'angl. gravimetry (1873 ds NED).DÉR. Gravimétrique, adj. a) Qui concerne, qui appartient à la gravimétrie (supra A). Carte, exploration gravimétrique. La balance de torsion gravimétrique de Leotvos (1895) a été aussi appliquée avec succès aux mesures gravimétriques relatives et à la prospection pétrolière (Hist. gén. sc., t. 3, vol. 2, 1964, p. 454). b) Qui fait intervenir la pesanteur (cf. Minéral. 1972). Pour les séparations gravimétriques, on a généralisé l'emploi de liqueurs lourdes variées et préconisé dans certains cas la centrifugation (Hist. gén. sc., t. 3, vol. 2, p. 483). c) Qui fait intervenir une pesée. Dosage, mesure gravimétrique. Des procédés gravimétriques et volumétriques satisfaisants étaient utilisables pour l'analyse de nombreuses substances minérales (Hist. gén. sc., t. 3, vol. 2p. 413). Il y a lieu de (...) distinguer [la densité réelle] de la densité gravimétrique, que l'on obtient en pesant un certain volume de poudre non tassée, c'est-à-dire sans tenir compte des vides existant entre les grains (LEDIEU, CADIAT, Nouv. matér. nav., 1890, p. 36). — [ ] — 1re attest. 1922 « relatif à la gravimétrie » (Lar. univ.); de gravimétrie, suff. -ique. Au sens de « qui a rapport au gravimètre » le mot est attesté dep. 1832 (RAYMOND).gravimétrie [gʀavimetʀi] n. f.ÉTYM. 1904, in Rev. gén. des sc., no 7, p. 351; sans doute antérieur (→ Gravimétrique); du lat. gravis « pesant », et -métrie.❖1 Phys. Mesure de l'intensité du champ de la pesanteur.2 Chim. Analyse quantitative par pesées.➪ tableau Vocabulaire de la chimie.

] — 1re attest. 1922 « relatif à la gravimétrie » (Lar. univ.); de gravimétrie, suff. -ique. Au sens de « qui a rapport au gravimètre » le mot est attesté dep. 1832 (RAYMOND).gravimétrie [gʀavimetʀi] n. f.ÉTYM. 1904, in Rev. gén. des sc., no 7, p. 351; sans doute antérieur (→ Gravimétrique); du lat. gravis « pesant », et -métrie.❖1 Phys. Mesure de l'intensité du champ de la pesanteur.2 Chim. Analyse quantitative par pesées.➪ tableau Vocabulaire de la chimie.

Encyclopédie Universelle. 2012.